作者:汤之上隆,编译:编辑部

自从2022年11月Open AI发布了ChatGPT以来,生成式AI(人工智能)在全球范围内迅速普及。这些生成式AI是在搭载了NVIDIA等AI半导体的AI服务器上运行的。

然而,根据TrendForce于去年2023年12月14日发布的预测,AI服务器的出货数量并没有如人们预期的那样增长。AI服务器在所有服务器出货数量中所占比例预测为:2022年为6%,2023年为9%,2024年为13%,2025年为14%,2026年为16%。

关于这个原因,笔者在此前的文章中进行了如下分析:

这个原因可以归结为AI半导体的供应瓶颈。目前,约占AI半导体80%的NVIDIA GPU在台积电进行前后工艺。后端工艺包括了所谓的CoWoS封装,而这种CoWoS的产能成为了瓶颈。

此外,在CoWoS中,GPU周围堆叠了多块HBM(高带宽存储器)DRAM,这种HBM也被认为是瓶颈之一。

那么,为什么台积电的CoWoS(Chip on Wafer on Substrate)产能一直不足呢?此外,尽管DRAM制造商有三家,即三星、SK海力士和美光,为什么HBM还是不足呢?

本文将对这些细节进行讨论,并且将阐述为什么NVIDIA等AI半导体短缺将持续数年以上。

01、台积电的中间工序是什么?

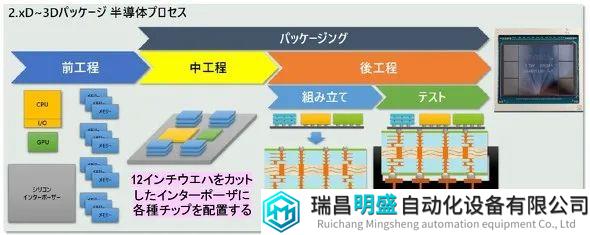

图 2 显示了 NVIDIA GPU 在台积电的制造方式。首先,在前端过程中,GPU、CPU、内存(DRAM)等是单独制造的。在这里,由于台积电不生产DRAM,因此它很可能从SK海力士等DRAM制造商那里获得HBM。

图2 2.5D-3D界面的中间工序,如NVIDIA GPU 资料来源:Tadashi Kamewada,“下一代半导体封装和封装技术趋势与市场展望”,科技研讨会,2024 年 2 月 6 日 幻灯片

接下来,将 GPU、CPU、HBM 等键合在“硅中介层”上,其中 12 英寸硅晶圆被切割成方形(晶圆上的芯片,即 CoW)。 硅中介层预制有连接芯片和硅通电极 (TSV) 的布线层。

这些工序被称为 “中间工序”。笔者对其中原因的解释是,中间工序被归类为后端工序,但在硅插层上形成的布线层等是使用前端工序的制造设备制造的。“中间工序” 一词之所以被使用,可能就是因为这一中间含义。

中间工序完成后,将中介层连接到基板(基板上的晶圆,即WoS),并进行各种测试以完成CoWoS封装。

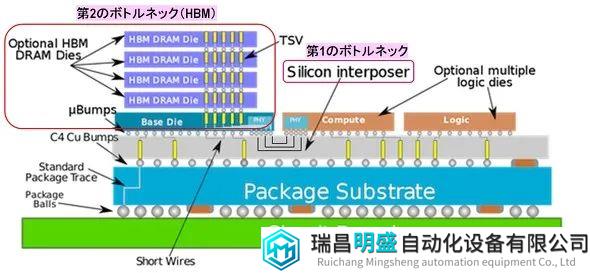

图3显示了CoWoS的横截面结构。在形成布线层和 TSV 的硅中介层上,键合了两个逻辑芯片,例如 GPU 和 CPU,以及堆叠了 DRAM 的 HBM。中介层通过C4(受控塌片连接)铜凸块与封装基板连接,基板通过封装球与电路板连接。

图3 CoWoS结构与英伟达GPU等AI半导体的两大瓶颈 资料来源:WikiChip

图3 CoWoS结构与英伟达GPU等AI半导体的两大瓶颈 资料来源:WikiChip

在这里,我们认为第一个瓶颈是中间工序中的硅中介层,第二个瓶颈是HBM。下面将解释其基本原理。

02、中介层越来越大,HBM的数量也有所增加

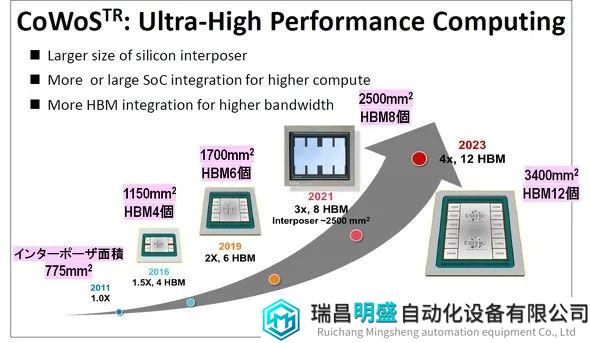

图 4 显示了自 2011 年以来 CoWoS 如何经历代际变化。 首先,我们可以看到硅中介层每一代都在变得越来越大,HBM 的搭载数量也在不断增加。

图 4 封装基板面积和HBM搭载数量不断增长 资料来源:K C Yee(TSMC),“Advanced 3D System Integration Technologies”,IEDM SC1,2020 年 12 月 13 日

图 5 显示了从 CoWoS Gen 1 到 Gen 6 的 12 英寸晶圆中安装的逻辑芯片类型、HBM 标准和安装数量、硅中介层面积以及可获得的中介层数量。

图 5 CoWoS 代次、HBM 安装数量、12 英寸晶圆中介层数量

图 5 CoWoS 代次、HBM 安装数量、12 英寸晶圆中介层数量

首先,可以看出,自第三代以来,HBM的搭载数量持续增长了1.5倍。 此外,HBM 的标准也发生了变化,性能也得到了提高(稍后会详细介绍)。 此外,随着中介层面积的增加,可以从 12 英寸晶圆获得的中介层数量减少。

但是,该数值只是”12英寸晶圆的面积除以中介层的面积的值”,实际得到的数值会更少。

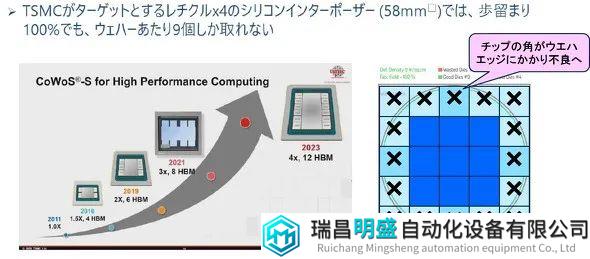

图 6 举例说明了这一点:2023 年发布的第 6 代 CoWoS 中介层面积为 3400 平方毫米,如果是正方形,则为 58 毫米 x 58 毫米(58 毫米正方形)。如果将这个 58 毫米的正方形铺设在 12 英寸的晶圆上,晶圆边缘的所有中介层都将有缺陷。因此,一个 12 英寸晶圆上最多只能获得 9 个 58 平方毫米的中介层。

图6 12英寸晶圆能获得多少个中介层

图6 12英寸晶圆能获得多少个中介层

资料来源:Tadashi Kamewada,“下一代半导体封装和封装技术趋势和市场展望”,科学与技术研讨会,2024年2月6日

此外,在中介层上形成布线层和TSV,但良率约为60-70%,因此从12英寸晶圆上可以获得的良好中介层数量最多为6个。

顺便提一下,采用这种58平方毫米的中介层制造的CoWoS 的代表性 GPU是英伟达的H100,该产品在市场上备受争夺,售价高达 4 万美元。

03、台积电的CoWoS产能不足

那么,台积电在CoWoS中间工序的产能有多大呢?产能足够吗?

在 2023 年 11 月 14 日举行的 DIGITIMES 研讨会“生成式 AI 浪潮中 2024 年全球服务器市场的机遇与挑战”(Jim Hsiao)上,据估计,其产能将从 2023 年第二季度的每月 1.3 万至 1.5 万片晶圆翻番至 2024 年第二季度的每月 3 万至 3.4 万片晶圆,从而缩小英伟达GPU 的供需缺口。

然而,这种前景还很遥远。 这是因为,截至 2024 年 4 月,NVIDIA 仍然没有足够的 GPU。 而TrendForce集邦咨询在4月16日的新闻中表示,到2024年底,台积电的CoWoS产能将达到每月40K左右,到2025年底将翻一番。毕竟,台积电的中间工序产能是不够的。

此外,TrendForce 的这则消息还提到,继 “H100 “之后,台积电还将推出下一代 “B100 “和 “B200″,而这些中介层的尺寸可能比 58 平方毫米的还要大。这意味着,从12英寸晶圆上可以获得的优质中介层数量将进一步减少,因此即使台积电拼命尝试增加CoWoS产能,也无法拥有足够的GPU来满足需求。可以说,这款GPU CoWoS中介层的巨大需求和台积电产能的增加,无论走多远都是一场“猫捉老鼠的游戏”,是一场永无止境的比赛。

为了结束这种“猫捉老鼠的游戏”,有人建议使用515×510毫米的方形基板代替12英寸晶圆作为中介层。此外,英特尔公司还提议使用矩形玻璃基板。当然,如果可以使用大型矩形基板,则可以比圆形12英寸晶圆更有效地获得大量中介层。

然而,要在矩形基板上形成布线层和TSV,需要专门的制造设备和运输系统。考虑到这些准备工作耗时长、成本高、难度大,因此目前看来“猫捉老鼠的游戏”并没有尽快解决的好办法。

现在,我想解释一下HBM的情况,这是另一个瓶颈。

04、HBM的路线图和DRAM制造商的命运

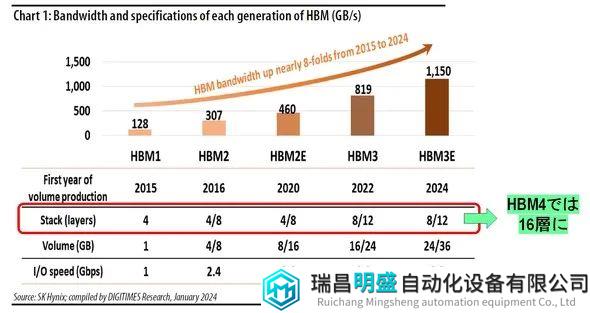

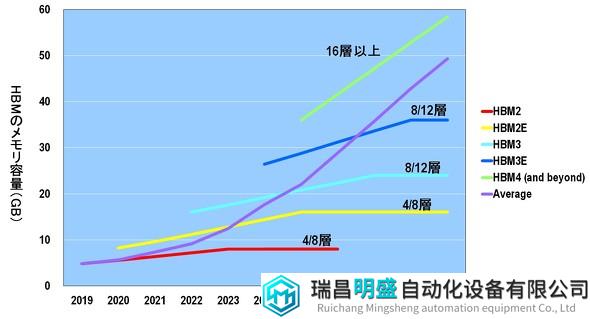

如图 4 和图 5 所示,HBM 的数量随着 CoWoS 的产生而增加,这也导致了中介层面积的扩张。DRAM 制造商仅仅按照相同的标准制造 HBM 是不够的:随着 CoWoS 的发展,他们必须提高 HBM 各方面的性能。HBM 路线图如图 7 所示。

图 7:HBM 路线图和 HBM 堆叠的 DRAM 数量

来源:报告“HBM 技术与容量发展”(2024 年 1 月),DIGI TIMES Research,“HBM 技术与容量发展”(2024 年 1 月)

首先,HBM 必须提高每秒交换数据的带宽,以配合 GPU 性能的提高。具体来说,2016 年 HBM1 的带宽为 128 GB/s,而 HBM3E 的带宽将扩大约 10 倍,达到 1150 GB/s,将于 2024 年发布。

接下来,HBM 的内存容量 (GB) 必须增加。 为此,有必要将堆叠在 HBM 中的 DRAM 芯片数量从 4 个增加到 12 个。下一代 HBM4 的 DRAM 层数预计将达到 16 层。

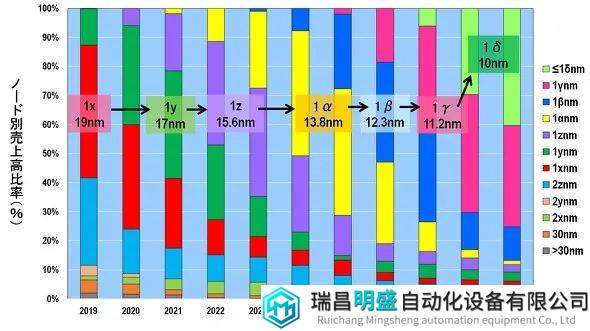

此外,HBM 的 I/O 速度 (GB/s) 也必须提高。为了同时实现所有这些目标,我们必须不惜一切代价实现DRAM的小型化。图8显示了按技术节点划分的DRAM销售比例的变化。2024 年将是从 1z (15.6 nm) 切换到 1α (13.8 nm) 的一年。 之后,小型化将以 1 nm 的增量进行,例如 1β (12.3 nm)、1γ (11.2 nm) 和 1δ (10 nm)。 这可能是DRAM厂商的命运。

图8 按技术节点划分的DRAM销售额百分比(%) 来源:作者根据Yole Intelligence的数据创建

图8 按技术节点划分的DRAM销售额百分比(%) 来源:作者根据Yole Intelligence的数据创建

请注意,括号中的数值是该代 DRAM 芯片中实际存在的最小加工尺寸。如今,器件分离的半间距(hp)是最小的,因此该尺寸已成为技术节点。 另一方面,例如在逻辑芯片中,即使台积电说它正在批量生产 3 纳米的芯片,但在芯片的任何地方都找不到 3 纳米的证据。换句话说,逻辑芯片的技术节点只是一个产品名称。

05、EUV也开始应用于DRAM

话题有些偏离,但DRAM制造商为了实现高度集成和高速化,确实需要进行1纳米级微细化。因此,为了形成微细图案,已经开始应用EUV(极紫外光)光刻技术(见图9)。

图9 各DRAM制造商应用EUV的层数 来源:基于Yole Intelligence的数据创作

图9 各DRAM制造商应用EUV的层数 来源:基于Yole Intelligence的数据创作

最早开始在DRAM中使用EUV技术的是三星,他们在Gen 1z只应用了一层。然而,这只是三星的逻辑芯片厂为了进行EUV应用的练习而借用的一个巨大的DRAM生产线,最大产量为每月1万块。因此,三星真正意义上开始在DRAM中使用EUV是从1α开始的,那时他们使用了5层EUV。

接下来,拥有HBM市场份额领先地位的SK海力士在1α时期应用了一层EUV。而今年2024年,他们计划转向1β,似乎打算在3-4层上应用EUV。因此,此前只拥有几台EUV的SK海力士计划在2024年引入10台EUV。值得一提的是,由于三星还有逻辑芯片厂,他们可能拥有30台以上的EUV。

最后,美光为了尽快推进技术节点,一直采取尽量不使用EUV的策略。实际上,他们在1β阶段也不使用EUV。此外,在1γ开发阶段,原计划也不使用EUV,而是采用ArF液浸+多重曝光技术,但由于技术上的难度逐渐增加,同时生产率的提升也变得困难,因此预计从1γ开始引入EUV。

这三家DRAM制造商目前使用的(或计划使用的)EUV的镜头开口数(NA)为0.33,但预计在2027年至2028年后期会考虑转向High NA。这样,DRAM制造商的微细化将持续不断。

那么,使用这样的最先进工艺,将能够生产多少HBM呢?

06、DRAM出货额和HBM出货额

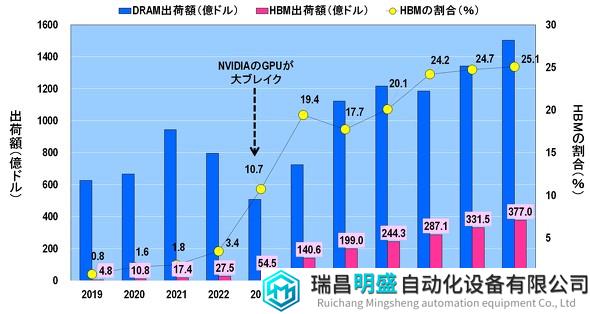

在图10中,显示了DRAM出货额、HBM出货额以及HBM占DRAM出货额比例。正如前文所述,ChatGPT于2022年11月发布,并且结果是,2023年NVIDIA的GPU大获成功。

图10 DRAM出货额、HBM出货额、HBM比例(%)来源:基于Yole Intelligence数据,作者制作

与此同时,HBM出货额也迅速增长。2022年HBM出货额为27.5亿美元(占3.4%),到了2023年增长了近两倍,达到54.5亿美元(占10.7%),2024年更是急剧增长到140.6亿美元(占19.4%)以上(括号内为HBM占DRAM出货额比例)。

关注DRAM出货额,可以看到在2021年因冠状病毒特需而达到顶峰,但到了2023年,特需结束后出货额大幅下降。之后,出货额逐渐回升,预计到2025年将超过2021年的峰值。而在2026年后,尽管会有些许波动,但将持续增长,预计到2029年将超过1500亿美元。

另一方面,预计HBM出货额将在2025年后继续增长,但HBM占DRAM出货额比例在2027年后将饱和在24-25%。这是为什么呢?

07、各种HBM的出货量和HBM的总出货量

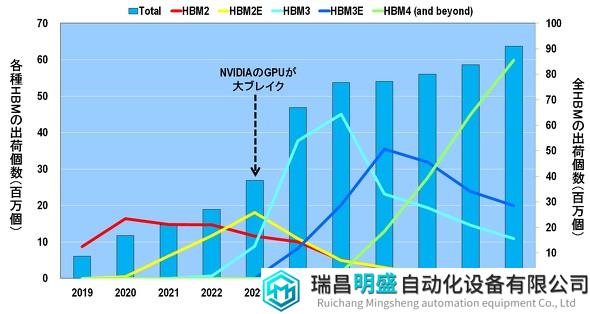

通过查看图 11 所示的各种 HBM 的出货量以及HBM出货总量的变化,可以解开这个谜团。

图11 各种HBM的出货量以及HBM的出货总量来源:基于Yole Intelligence数据,作者制作

首先,到2022年为止,主要出货的是HBM2。接着,在NVIDIA的GPU于2023年大热之后,HBM2E取代HBM2成为主角。然后,在2024年到2025年之间,HBM3将成为主流。再者,到2026年到2027年之间,HBM3E的出货量最多,而2028年开始则由HBM4主导。

也就是说,HBM大致上以两年为周期进行世代更替。这意味着DRAM制造商不仅需要在微细化方面以1纳米为单位前进,还需要每两年更新一次HBM的规格。

因此,从图11可以明显看出,HBM的出货总量在2025年后几乎没有增长。这并不是DRAM制造商懈怠的结果,而是因为他们需要全力生产最先进的DRAM,同时还要制造最先进的HBM。

此外,导致HBM出货总量在2025年后增长不大的原因之一是,堆叠在HBM内的DRAM芯片数量增加了(见图12)。随着GPU性能的提升,HBM的内存容量(GB)也必须增加,因此HBM内的DRAM堆叠层数从HBM2和HBM2E的4至8层增加到HBM3和HBM3E的8至12层,最后到HBM4则为16层。

图12 各种HBM的内存容量(GB)以及HBM内的DRAM芯片堆叠层数 来源:基于Yole Intelligence数据,作者制作

也就是说,HBM2只需要4至8层DRAM,但到了HBM4则需要2至4倍的16层DRAM。因此,DRAM制造商在HBM4时代可能会生产2至4倍于HBM2时代的DRAM,但HBM的出货量可能会保持相同水平。

综上所述,由于DRAM持续以1纳米为单位进行微细化,HBM大约每两年进行世代更替,以及HBM内的DRAM随着世代增加,预计2025年后HBM的出货总量将达到饱和。

那么,HBM短缺会持续下去吗?DRAM制造商不能进一步增加HBM的出货量吗?

08、DRAM制造商迫切希望大规模生产HBM

虽然已经解释了DRAM制造商无法迅速增加HBM出货量的原因,但即便如此,DRAM制造商仍将挑战其极限,全力以赴地量产HBM。这是因为HBM的价格非常高昂。

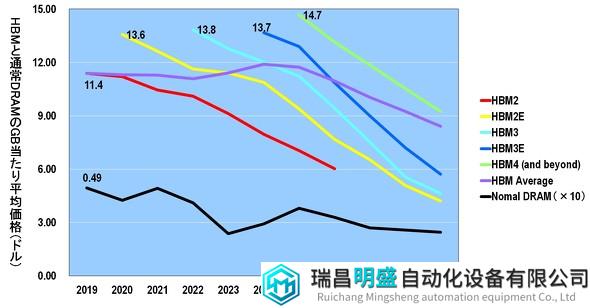

图13展示了各种HBM和常规DRAM每GB平均价格的对比图表。无论是常规DRAM还是HBM,它们在发布时的每GB价格都是最高的。虽然趋势相同,但常规DRAM和HBM每GB的价格相差20倍以上。需要注意的是,在图13中,为了比较常规DRAM和HBM每GB的平均价格,将常规DRAM的价格放大了10倍并标记在图表上。

图13 各种HBM和常规DRAM每GB平均价格的对比 来源:基于Yole Intelligence数据,作者制作

直接比较发布后价格最高的情况,常规DRAM每GB的价格为0.49美元,而HBM2为其约23倍的11.4美元,HBM2E为约28倍的13.6美元,HBM4则为30倍的14.7美元。

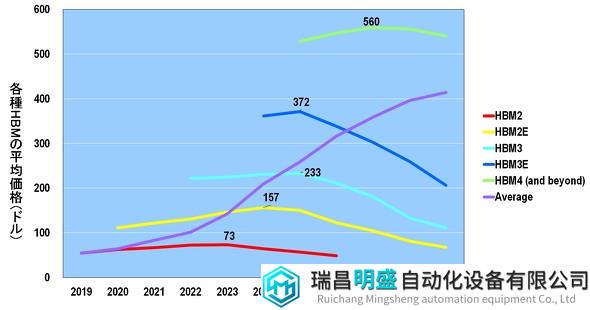

此外,图14展示了各种HBM的平均价格图表。在价格最高的情况下,HBM2为73美元,HBM2E为157美元,HBM3为233美元,HBM3E为372美元,而HBM4则高达560美元。

图14 各种HBM和常规DRAM每GB平均价格的对比 来源:基于Yole Intelligence数据,作者制作

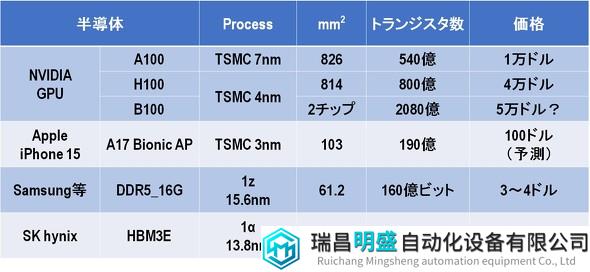

图15显示了HBM的价格有多昂贵。例如,DRAM制造商在1z工艺下生产的DDR5 16GB的DRAM的价格最多为3至4美元。然而,今年(2024年),SK 海力士发布的HBM3E却高达其90至120倍的361美元。

需要说明的是,DDR(Double Data Rate)是内存标准的一种。数据传输速度越来越快,DDR5比DDR4快2倍,DDR6比DDR5快2倍。2024年是从DDR4转向DDR5的一年,DRAM制造商需要不断更新DDR标准。

图15 各种半导体的工艺、芯片尺寸、晶体管数量(位数)、平均价格的对比

图15 各种半导体的工艺、芯片尺寸、晶体管数量(位数)、平均价格的对比

回到HBM,HBM3E使用TSMC最先进的3nm工艺生产,与最新款“iPhone 15”用的“A17 Bionic” AP(应用处理器)几乎相同的芯片尺寸,但价格高达其3.6倍。相比于先进的逻辑芯片,DRAM的HBM更昂贵,这令人震惊。因此,由于这种高昂的价格,DRAM制造商将全力以赴增加HBM的出货量,以夺取HBM的主导地位。

让我们来看看三家DRAM制造商的路线图。

09、DRAM制造商争夺HBM

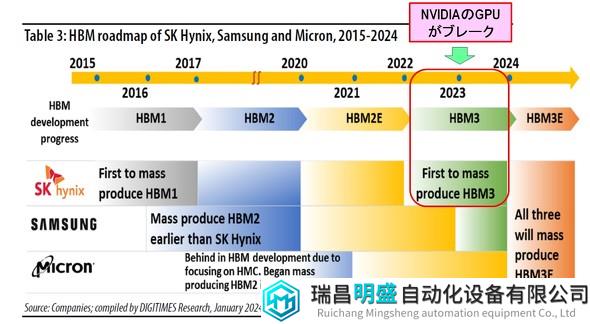

图16展示了在2015年至2024年期间,三家DRAM制造商是如何生产HBM的。

图16 SK 海力士、Samsung、Micron的HBM路线图 来源:DIGITIMES Research, ”HBM Technology and capacity development”(2024年1月)报告中的图表

图16 SK 海力士、Samsung、Micron的HBM路线图 来源:DIGITIMES Research, ”HBM Technology and capacity development”(2024年1月)报告中的图表

首先成功量产HBM1的是SK海力士。

然而,在HBM2时代,三星比SK海力士更早实现了量产。然后,在2023年NVIDIA的GPU大获成功时,SK海力士恰巧比其他公司更早实现了HBM3的量产。这使得SK 海力士获得了巨大利益。结果,DRAM冠军三星落后了。

另一方面,另一家DRAM制造商美光最初开发的是与HBM不同的HMC(混合内存立方体)标准。然而,美国半导体标准化推进组织JEDEC(联合电子设备工程委员会)正式认证了HBM而非HMC的标准。因此,美光从2018年开始放弃了HMC的开发,并在大幅落后于韩国两家制造商之后参与了HBM的开发。

根据2024年3月20日Bloomberg的报道,HBM的市场中,SK海力士占54%,三星占41%,美光占5%。

市场份额排名第一的SK海力士于2023年在NAND工厂M15开始生产HBM。此外,他们计划在2024年上半年发布HBM3E。而在2025年,他们计划将目前正在建设中的M15X工厂改造为专用的HBM工厂,用于生产HBM3E和HBM4。

另一方面,希望赶上SK海力士的三星于2023年开始在Samsung Display工厂生产HBM,并计划在2024年将HBM产能扩大两倍,在2025年比SK海力士更早开始量产HBM4。

落后的美光则跳过了HBM3,计划在2024至2025年通过HBM3E竞争,并在2025年争取获得20%的市场份额。此外,在2027至2028年间,他们计划通过量产HBM4和HBM4E来赶上领先的韩国两家制造商。

通过三家DRAM制造商的激烈竞争,可能打破HBM出货总量饱和的状态,从而有望解决HBM短缺问题。

10、NVIDIA的GPU短缺会持续多久?

本文解释了全球范围内NVIDIA GPU等AI半导体短缺的原因。这些原因可以总结为以下两点:

1)NVIDIA的GPU采用台积电的CoWoS封装技术。然而,CoWoS的产能完全不足。原因在于,GPU、CPU、HBM等芯片所搭载的硅中介层随着世代更新而变得越来越大。台积电正试图增加这种中间工艺的产能,但随着GPU世代的更新,中介层也会变得更大,这可能导致一直处于“你追我赶”的状态。

2)搭载在CoWoS中的HBM也存在短缺。原因是,DRAM制造商不仅需要以1nm的微细度进行持续缩小,还必须每两年更新一次HBM的规格,同时随着世代的变化,HBM中的DRAM芯片也在增加。DRAM制造商正在全力生产HBM,但据预测,到2025年后HBM的供应将达到饱和。然而,由于HBM价格极高,DRAM制造商正展开激烈的竞争,这可能有助于解决HBM短缺问题。

因此,导致NVIDIA的GPU短缺的瓶颈问题包括台积电中间工艺产能不足和HBM短缺这两点,但这些问题短时间内很难解决。因此,预计NVIDIA的GPU短缺将持续数年(甚至更长时间?)。