【与非网报道】暌违五年,英伟达GTC大会终于重回线下,于太平洋时间3月18日至21日在美国圣何塞会议中心举行。当前,正值生成式AI席卷全球科技领域,英伟达GTC也已然成为全球瞩目的AI盛宴,它不仅是AI领域的风向标,也是AI生态力量的一次盛大集结。

在这场科技狂欢中,下一代GPU架构、AI大模型趋势、人形机器人、自动驾驶等前沿技术,无疑是最受关注的焦点。它们不仅代表着AI技术的最新进展,也预示着未来计算平台和开发模式的新挑战与新机遇。

GTC 2024期间,<与非网>在圣何塞见证这些AI变革力量的诞生和发布,这篇文章抓取了最重磅的消息和趋势。

新一代GPU架构Blackwell发布,云厂商和生成式AI巨头继续跟进

当前,企业级用户正在重新审视AI基础设施的投入和部署,而对云厂商来说,如何高效支持先进的加速工作负载会是未来采用GPU的巨大动力。不仅如此,在科学计算、数据分析、机器学习等众多领域,对强大GPU的需求远远没有见顶。

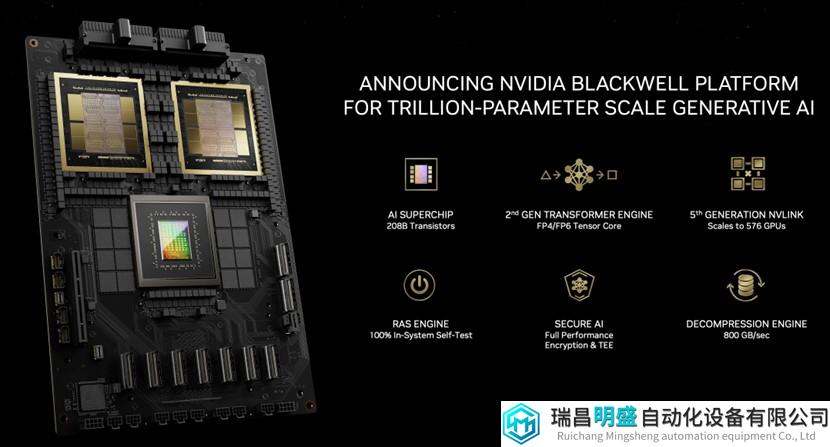

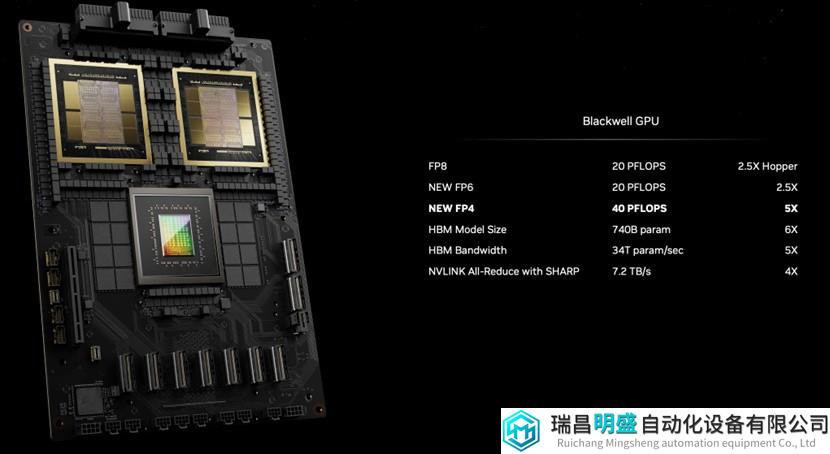

GTC 2024上,英伟达宣布推出Blackwell平台,通过全新的Blackwell GPU、NVLink和弹性技术,可以支持万亿参数规模的AI模型,新的Tensor核心和TensorRT-LLM 编译器,可将LLM推理运营成本和能源降低高达25倍,有助于实现数据处理、工程仿真、电子设计自动化、计算机辅助药物设计和量子计算方面的突破。

在新一代Blackwell宣布的同时,AWS、Dell、Google、Meta、Microsoft、OpenAI、Oracle、Tesla和xAI等纷纷站台,表示支持和看好。

前不久传出7万亿造芯的OpenAI 首席执行官 Sam Altman表示:“Blackwell 实现了巨大的性能飞跃,并将加快我们交付领先模型的能力,我们很高兴继续与英伟达合作来增强 AI 计算。”

Tesla 和 xAI 首席执行官埃隆·马斯克 (Elon Musk)更是直言:“目前没有什么比英伟达硬件更好的AI硬件了。”

Blackwell具有六项革命性的技术突破:

第一,采用Blackwell架构的新一代GPU内含2080亿个晶体管,采用台积电定制的4NP工艺制造。将两个GPU die通过10 TB/秒的芯片到芯片链路,连接成一个GPU。

第二,内置第二代Transformer引擎——由新的micro-tensor驱动。Blackwell凭借扩展支持以及集成了NVIDIA TensorRT-LLM和NeMo Megatron框架中的先进动态范围管理算法,能够通过新的4位浮点AI推理功能支持双倍的计算和模型大小。

第三,第五代NVLink为每个GPU提供了突破性的1.8TB/s 双向吞吐量,能够支持最复杂的LLM所需的576个GPU之间的无缝高速通信,从而可以加速数万亿参数和混合专家AI模型的性能。

第四,基于Blackwell的GPU包含一个专用的RAS引擎,可实现可靠性、可用性和可服务性。此外,Blackwell 架构还增加了芯片级功能,利用基于AI的预防性维护来运行诊断和预测可靠性问题。这可以最大限度地延长系统正常运行时间并提高大规模AI部署的弹性,使其能够连续运行数周甚至数月,并降低运营成本。

第五,安全AI。通过先进的机密计算功能,可在不影响性能的情况下保护AI模型和客户数据,并支持新的本机接口加密协议,这对于医疗保健和金融服务等隐私敏感行业至关重要。

第六,解压缩引擎。通过专用的解压缩引擎来支持最新格式,加速数据库查询,以提供数据分析和数据科学的最高性能。预测未来几年,企业每年花费数百亿美元的数据处理将越来越多地由GPU加速。

上述六大革命性技术共同支持AI训练和实时LLM推理,模型可扩展至10万亿参数,继续推动加速计算和生成式AI的发展。

沿袭历代GPU架构的命名规则,Blackwell新架构继续致敬了一位重要学者——专门研究博弈论和统计学的数学家David Harold Blackwell,他也是第一位入选美国国家科学院的黑人学者。

GB200算力“大杀器“

GB200超级芯片由两个B200 Tensor Core GPU和一个Grace CPU组成,采用900GB/s超低功耗NVLink芯片互连技术,通过这样强大的系统设计,实现了一款算力“大杀器”。

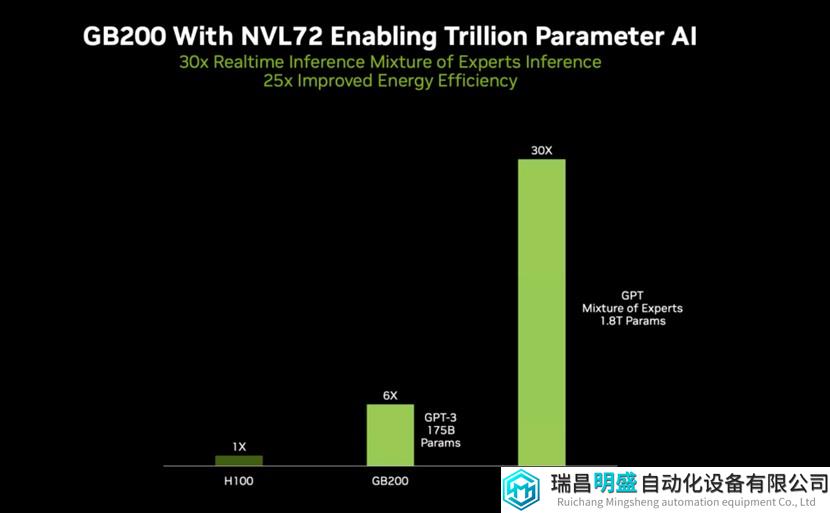

随着GB200的发布,英伟达还宣布了一款多节点、具备液冷和机架规模的系统NVIDIA GB200 NVL72,适用于计算最密集的工作负载。它结合了36个Grace Blackwell超级芯片,包括通过第五代NVLink互连的72个Blackwell GPU和36个Grace CPU。

此外,GB200 NVL72 还包括BlueField-3 数据处理单元,可在超大规模AI云中实现云网络加速、可组合存储、零信任安全性和GPU计算弹性。

与含有相同数量的H100 Tensor Core GPU系统相比,GB200 NVL72对于LLM推理工作负载的性能提升高达30倍,并将成本和能耗降低高达25倍。

8颗B200 GPU+2颗第五代英特尔至强,DGX B200推进行业AI超级计算

英伟达还发布了用于AI模型训练、调优和推理的通用AI超级计算平台NVIDIA DGX B200 系统,这是DGX系列的第六代产品。

采用Blackwell架构的全新 DGX B200系统,包含8颗 NVIDIA B200 Tensor Core GPU和2颗第五代英特尔至强处理器。此外,还包含带有8个NVIDIA ConnectX-7网卡和2颗BlueField-3 DPU的高性能网络,每个连接的带宽高达400 Gb/s,可通过Quantum-2 InfiniBand和Spectrum-X以太网网络平台支持更高的 AI 性能。

凭借全新 Blackwell架构中的FP4精度特性,DGX B200系统可提供高达144 petaflops的 AI性能、1.4TB 海量的GPU显存和64TB/s的显存带宽,从而使得该系统的万亿参数模型实时推理速度比上一代产品提升了15倍。

面向生成式AI,全新机架级扩展的DGX SuperPOD架构

新一代AI超级计算机DGX SuperPOD,搭载了GB200 Grace Blackwell超级芯片,可处理万亿参数模型,用于超大规模AI训练和推理工作负载。该计算机采用高效液冷架构,由DGX GB200系统构建,在FP4精度下可提供11.5 exaflops的AI超级计算性能和240 TB的快速显存,且可通过增加机架来扩展性能。

每个DGX GB200系统搭载有36个GB200超级芯片,共包含36颗Grace CPU和72颗Blackwell GPU。这些超级芯片通过第五代NVLink连接成一台超级计算机。与NVIDIA H100 Tensor Core GPU 相比,GB200 超级芯片在大语言模型推理工作负载方面的性能提升了高达45倍。

Grace Blackwell 架构的 DGX SuperPOD 由 8 个或以上的 DGX GB200 系统构建而成,这些系统通过 NVIDIA Quantum InfiniBand 网络连接,可扩展到数万个 GB200 超级芯片。用户可通过 NVLink 连接 8 个 DGX GB200 系统中的 576 颗 Blackwell GPU,从而获得海量共享显存空间,来赋能下一代 AI 模型。

此外,DGX SuperPOD具有智能预测管理功能,能够持续监控软硬件中的数千个数据点,通过预测并拦截导致停机和低效的根源以节省时间、能耗和计算成本。即使没有系统管理员在场,该软件也能识别需要重点关注的领域并制定维护计划,灵活调整计算资源,通过自动保存和恢复作业来防止停机。

预计英伟达全球合作伙伴将在今年晚些时候提供基于DGX GB200和DGX B200系统构建而成的 NVIDIA DGX SuperPOD。

DRIVE Thor集中式车载计算平台,为生成式AI而打造

DRIVE Thor 是英伟达专为汽车行业中日益重要的生成式AI应用而打造的车载计算平台。作为DRIVE Orin 的后续产品,DRIVE Thor可提供丰富的座舱功能,以及安全可靠的高度自动化驾驶和无人驾驶功能,并将所有功能整合至同一个集中式平台上。

黄仁勋宣布,这款新一代自动驾驶汽车(AV)处理器基于全新的Blackwell架构,专为Transformer、大语言模型(LLM)和生成式AI工作负载而打造。交通运输领域的领先企业已采用DRIVE Thor为其下一代乘用车和商用车提供助力,其中包括新能源汽车(NEV)、卡车、自动驾驶出租车、自动驾驶公交车和为“最后一公里”而生的自动驾驶配送车等。

NVIDIA汽车事业部副总裁吴新宙表示:“加速计算为生成式AI等领域带来了变革性突破,而生成式AI则正在重新定义自动驾驶和全球交通运输业。DRIVE Orin仍然是当今智能车型首选的AI车载计算平台,同时,我们看到移动出行领域的领先企业富有远见地将NVIDIA DRIVE Thor纳入其下一代AI汽车产品路线图中。”

DRIVE Thor被认为将彻底改变汽车行业的格局,开创生成式AI定义驾驶体验的时代。多家头部电动汽车制造商都在GTC上展示了搭载DRIVE Thor的下一代AI车型:

比亚迪正在将与英伟达的长期协作从车端延伸到云端。除了在 DRIVE Thor上构建下一代电动车型外,比亚迪还计划将英伟达的AI基础设施用于云端AI开发和训练,并使用NVIDIA Isaac与Omniverse平台来开发用于虚拟工厂规划和零售配置器的工具与应用。

广汽埃安旗下高端豪华品牌昊铂宣布其下一代电动汽车将采用DRIVE Thor平台,新车型将于 2025 年开始量产。昊铂目前的旗舰车型昊铂GT搭载了DRIVE Orin,该车型具备先进的 L2+级高速自动驾驶能力。

小鹏宣布将把NVIDIA DRIVE Thor平台作为其下一代电动汽车的“AI大脑”。这款新一代车载计算平台将助力该电动汽车制造商自研的 XNGP智能辅助驾驶系统,实现自动驾驶和泊车、驾乘人员监控等功能。

此前,理想汽车和极氪也均已宣布将在DRIVE Thor上构建其未来的汽车产品。

除乘用车外,DRIVE Thor还能够满足卡车、自动驾驶出租车、配送车等其他细分领域的不同需求。在这些领域中,高性能计算和AI对于确保安全、可靠的驾驶操作至关重要。

Nuro致力于开发用于商用车和乘用车的L4级自动驾驶技术,该公司选择DRIVE Thor为Nuro Driver提供助力。

自动驾驶软件解决方案提供商Plus宣布其L4级解决方案SuperDrive的下一代产品将在DRIVE Thor车规级集中式计算平台上运行,Plus的自动驾驶系统将充分利用DRIVE Thor 的计算性能,以了解卡车周围的环境并做出安全的驾驶决策。

文远知行正在与联想车计算一同基于DRIVE Thor来创建多个商用L4级自动驾驶解决方案。该解决方案集成在联想首款自动驾驶域控制器 AD1中,将被用于各种以城市为中心的用例,具备功能安全、冗余安全设计、融合可扩展等技术特点。

据介绍,DRIVE Thor预计最早将于明年开始量产,并且将使用具有生成式AI引擎等前沿功能的全新NVIDIA Blackwell架构。DRIVE Thor的性能高达1000 TFLOPS,有助于保证自动驾驶汽车的安全可靠。

专为人形机器人打造——通用基础模型和全新的计算平台

黄仁勋将通用人形机器人基础模型视作当今AI领域中最令人兴奋的课题之一,在GTC上发布了人形机器人通用基础模型 Project GR00T,旨在进一步推动其在机器人和具身智能方面的突破。GR00T 驱动的机器人将能够理解自然语言,并通过观察人类行为来模仿动作——快速学习协调、灵活性和其它技能,以便导航、适应现实世界并与之互动。

同时发布的还有基于Thor SoC芯片的新型人形机器人计算机 Jetson Thor,它是一个全新的计算平台,能够执行复杂的任务并安全、自然地与人和机器交互,具有针对性能、功耗和尺寸优化的模块化架构。

该SoC包括一个带有 transformer engine的GPU,采用 NVIDIA Blackwell 架构,可提供每秒 800 万亿次8位浮点运算AI性能,以运行GR00T等多模态生成式AI模型。凭借集成的功能安全处理器、高性能CPU集群和100GB以太网带宽,大大简化了设计和集成工作。

此外,英伟达对Isaac机器人平台进行了重大升级,包括生成式 AI 基础模型和仿真工具,以及 AI 工作流基础设施。GR00T 使用的Isaac工具还能够为在任何环境中的任何机器人创建新的基础模型。这些工具包括用于强化学习的Isaac Lab 和用于计算编排服务的 OSMO。

由于训练具身智能模型需要海量的真实数据和合成数据,新的Isaac Lab作为一个 GPU 加速、性能优化的轻量级应用,基于 Isaac Sim 而构建,可专门用于运行数千个用于机器人学习的并行仿真。

英伟达还发布了Isaac Manipulator 和 Isaac Perceptor 等一系列机器人预训练模型、库和参考硬件。Isaac Manipulator为机械臂提供了卓越的灵活性和模块化 AI 功能,并提供了一系列强大的基础模型和 GPU 加速库。它提供了高达 80 倍的路径规划加速,零样本感知提高了效率和吞吐量,使开发者能够实现更多新的机器人任务的自动化。Isaac Perceptor提供了多摄像头和 3D 环绕视觉功能,这些功能正越来越多地被制造业和物流业中的自主移动机器人所采用,以提高效率和更好地保护工人,同时降低错误率和成本。ArcBest、比亚迪和凯傲集团等公司是这些全新高级视觉 AI 功能的早期行业合作伙伴,为物料搬运等操作带来了新的自主化水平。

以API形式提供Omniverse Cloud

黄仁勋一直对制造业的数字孪生寄予厚望,而Omniverse就是一个可以构建并操作物理真实的数字孪生的操作系统。他认为,Omniverse和生成式AI都是将价值高达50万亿美元的重工业市场,进行数字化所需的基础技术。

英伟达宣布将以API形式提供Omniverse Cloud,从而将工业数字孪生应用和工作流创建平台的覆盖范围扩展至整个软件制造商生态系统。

借助五个全新Omniverse Cloud应用编程接口(API),开发者能够轻松地将Omniverse的核心技术直接集成到现有的数字孪生设计与自动化软件应用中,或是集成到用于测试和验证机器人或自动驾驶汽车等自主机器的仿真工作流中。

这五个Omniverse Cloud API既可单独使用,也可组合使用。它们分别是:

USD Render:生成OpenUSD数据的全光线追踪RTX™渲染

USD Write:让用户能够修改OpenUSD数据并与之交互

USD Query:支持场景查询和交互式场景

USD Notify:追踪USD变化并提供更新信息

Omniverse Channel:连接用户、工具和世界,实现跨场景协作

一些全球大型工业软件制造商正在将Omniverse Cloud API加入到其软件组合中,包括 Ansys、Cadence、达索系统旗下3DEXCITE品牌、Hexagon、微软、罗克韦尔自动化、西门子和Trimble等。

西门子就在Xcelerator平台中采用了Omniverse Cloud API,首先采用的是领先的云端产品生命周期管理(PLM)软件Teamcenter X。黄仁勋现场展示了Teamcenter X与Omniverse API的连接,这能打通设计数据到NVIDIA生成式AI API之间的通路,且允许在该应用内直接使用Omniverse RTX渲染。

西门子总裁兼首席执行官Roland Busch表示:“通过NVIDIA Omniverse API,西门子能够利用生成式AI赋能客户,使其符合物理学的数字孪生变得更具沉浸感。这将帮助所有人在实际建造前,对下一代产品、制造流程和工厂进行虚拟设计、建造和测试。通过将现实世界与数字世界相结合,西门子数字孪生技术正在帮助全球企业提高竞争力、弹性和可持续发展能力。”

写在最后

“加速计算已经达到了临界点——通用计算已经失去了动力”,黄仁勋在演讲中说道。他强调,“我们需要更大的GPU,Blackwell平台就是为了应对这一挑战而构建的。黄左手举起H100,右手是最新的Blackwell GPU。H100“最强GPU”的王座瞬间失去,不过这不就是英伟达一路劈荆斩棘、右拳打左拳的进化动力?代代更迭,一路向前。